HackWare.ru

Этичный хакинг и тестирование на проникновение, информационная безопасность

Веб-архивы Интернета: как искать удалённую информацию и восстанавливать сайты

Что такое Wayback Machine и Архивы Интернета

В этой статье мы рассмотрим Веб Архивы сайтов или Интернет архивы: как искать удалённую с сайтов информацию, как скачать больше несуществующие сайты и другие примеры и случаи использования.

Принцип работы всех Интернет Архивов схожий: кто-то (любой пользователь) указывает страницу для сохранения. Интернет Архив скачивает её, в том числе текст, изображения и стили оформления, а затем сохраняет. По запросу сохранённые страницу могут быть просмотрены из Интернет Архива, при этом не имеет значения, если исходная страница изменилась или сайт в данный момент недоступен или вовсе перестал существовать.

Многие Интернет Архивы хранят несколько версий одной и той же страницы, делая её снимок в разное время. Благодаря этому можно проследить историю изменения сайта или веб-страницы в течение всех лет существования.

В этой статье будет показано, как находить удалённую или изменённую информацию, как использовать Интернет Архивы для восстановления сайтов, отдельных страниц или файлов, а также некоторые другие случае использования.

Wayback Machine — это название одного из популярного веб архива сайтов. Иногда Wayback Machine используется как синоним «Интернет Архив».

Какие существуют веб-архивы Интернета

Я знаю о трёх архивах веб-сайтов (если вы знаете больше, то пишите их в комментариях):

web.archive.org

Этот сервис веб архива ещё известен как Wayback Machine. Имеет разные дополнительные функции, чаще всего используется инструментами по восстановлению сайтов и информации.

Для сохранения страницы в архив перейдите по адресу https://archive.org/web/ введите адрес интересующей вас страницы и нажмите кнопку «SAVE PAGE».

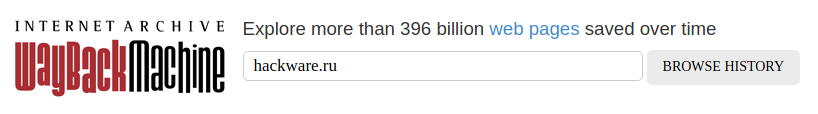

Для просмотра доступных сохранённых версий веб-страницы, перейдите по адресу https://archive.org/web/, введите адрес интересующей вас страницы или домен веб-сайта и нажмите «BROWSE HISTORY»:

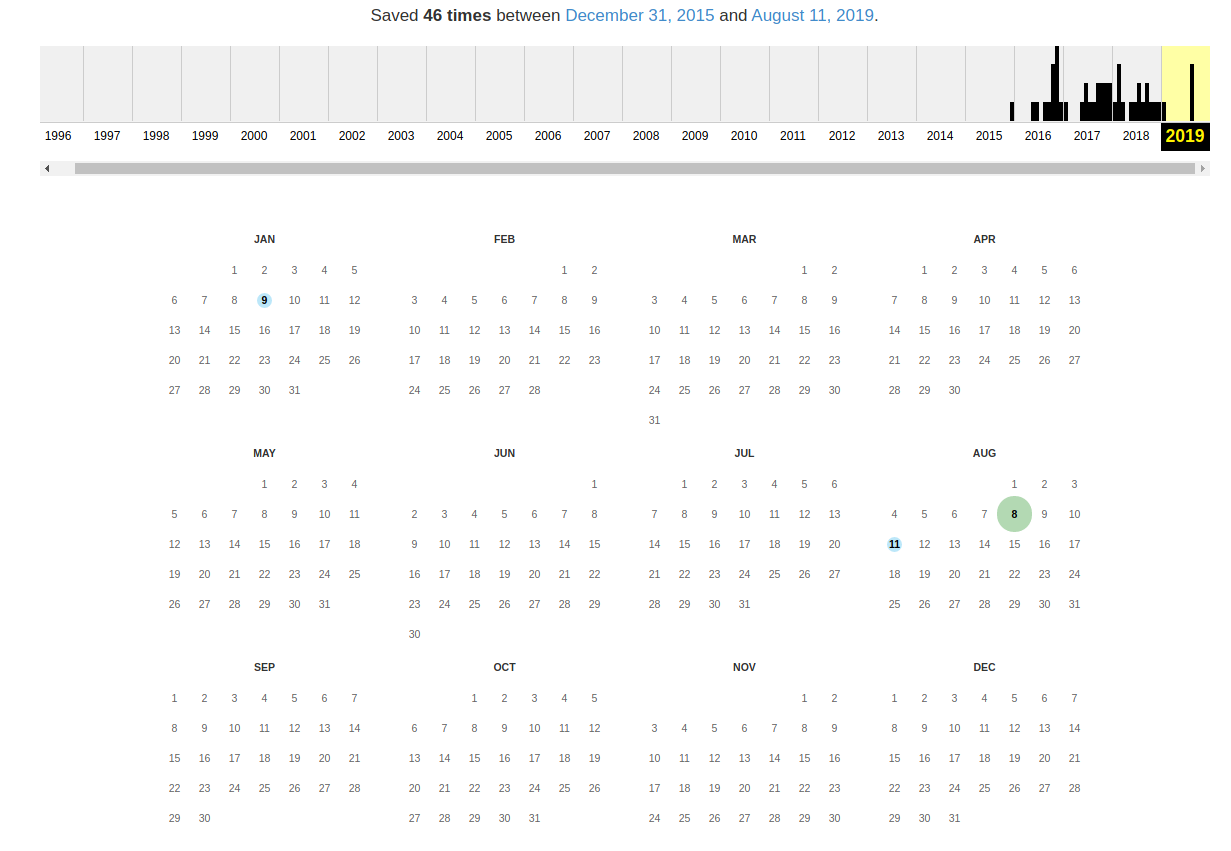

В самом верху написано, сколько всего снимком страницы сделано, дата первого и последнего снимка.

Затем идёт шкала времени на которой можно выбрать интересующий год, при выборе года, будет обновляться календарь.

Обратите внимание, что календарь показывает не количество изменений на сайте, а количество раз, когда был сделан архив страницы.

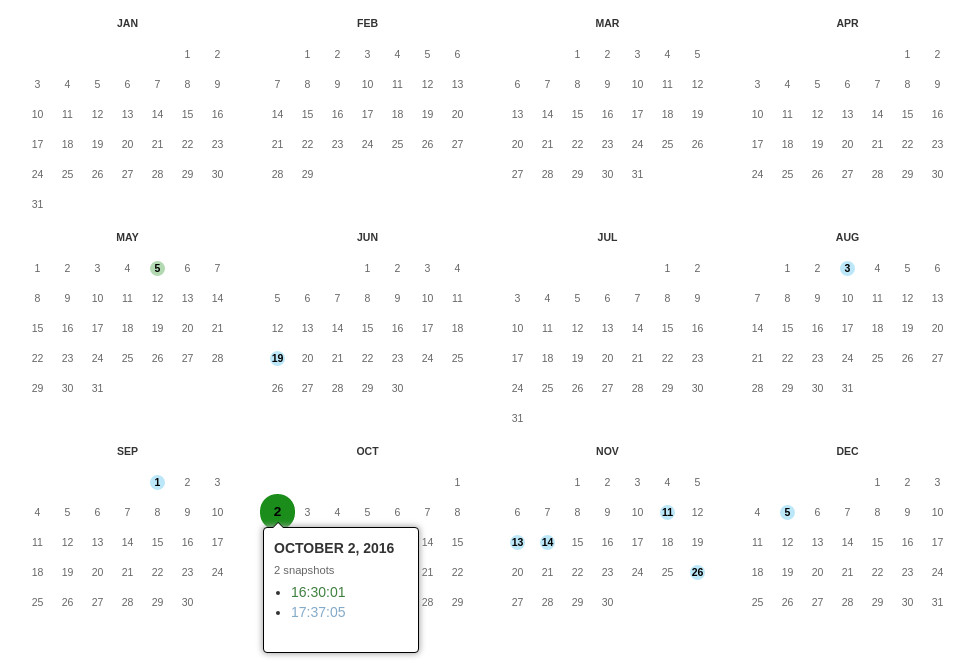

Точки на календаре означают разные события, разные цвета несут разный смысл о веб захвате. Голубой означает, что при архивации страницы от веб-сервера был получен код ответа 2nn (всё хорошо); зелёный означает, что архиватор получил статус 3nn (перенаправление); оранжевый означает, что получен статус 4nn (ошибка на стороне клиента, например, страница не найдена), а красный означает, что при архивации получена ошибка 5nn (проблемы на сервере). Вероятно, чаще всего вас должны интересовать голубые и зелёные точки и ссылки.

При клике на выбранное время, будет открыта ссылка, например, http://web.archive.org/web/20160803222240/https://hackware.ru/ и вам будет показано, как выглядела страница в то время:

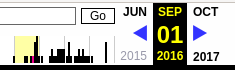

Используя эту миниатюру вы сможете переходить к следующему снимку страницы, либо перепрыгнуть к нужной дате:

Лучший способ увидеть все файлы, которые были архивированы для определённого сайта, это открыть ссылку вида http://web.archive.org/*/www.yoursite.com/*, например, http://web.archive.org/*/hackware.ru/

Кроме календаря доступна следующие страницы:

Changes

«Changes» — это инструмент, который вы можете использовать для идентификации и отображения изменений в содержимом заархивированных URL.

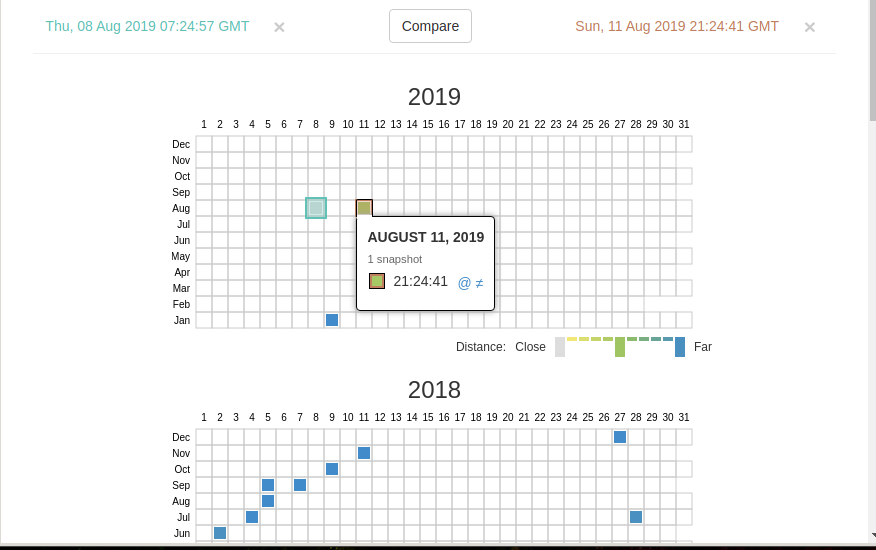

Начать вы можете с того, что выберите два различных дня какого-то URL. Для этого кликните на соответствующие точки:

И нажмите кнопку Compare. В результате будут показаны два варианта страницы. Жёлтый цвет показывает удалённый контент, а голубой цвет показывает добавленный контент.

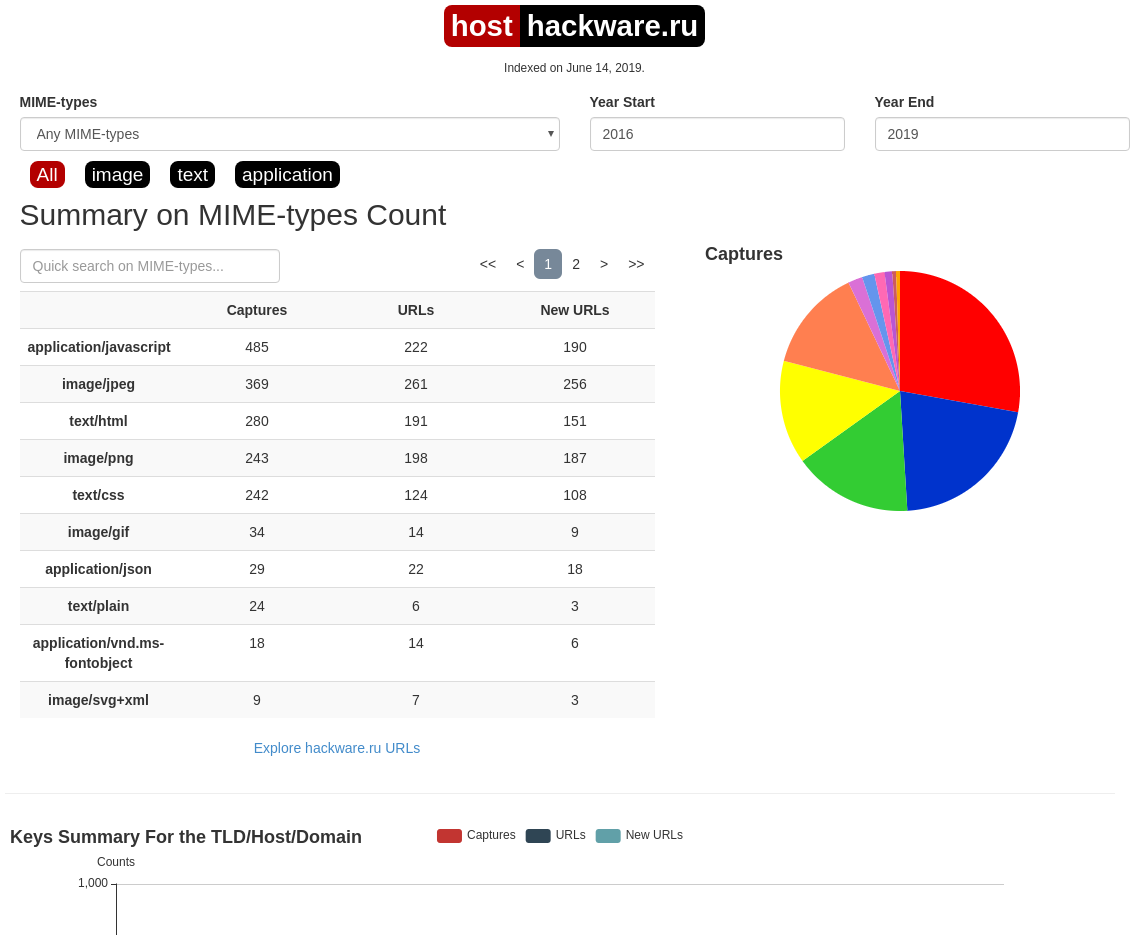

Summary

В этой вкладке статистика о количестве изменений MIME-типов.

Site Map

Как следует из название, здесь показывается диаграмма карты сайта, используя которую вы можете перейти к архиву интересующей вас страницы.

Поиск по Интернет архиву

Если вместо адреса страницы вы введёте что-то другое, то будет выполнен поиск по архивированным сайтам:

Показ страницы на определённую дату

Кроме использования календаря для перехода к нужной дате, вы можете просмотреть страницу на нужную дату используя ссылку следующего вида: http://web.archive.org/web/ГГГГММДДЧЧММСС/АДРЕС_СТРАНИЦЫ/

Обратите внимание, что в строке ГГГГММДДЧЧММСС можно пропустить любое количество конечных цифр.

Если на нужную дату не найдена архивная копия, то будет показана версия на ближайшую имеющуюся дату.

archive.md

Адреса данного Архива Интернета:

На главной странице говорящие за себя поля:

Для поиска по сохранённым страницам можно как указывать конкретный URL, так и домены, например:

Данный сервис сохраняет следующие части страницы:

Не сохраняются следующие части веб-страниц:

Архивируемая страница и все изображения должны быть менее 50 Мегабайт.

Для каждой архивированной страницы создаётся ссылка вида http://archive.is/XXXXX, где XXXXX это уникальный идентификатор страницы. Также к любой сохранённой странице можно получить доступ следующим образом:

Дату можно продолжить далее, указав часы, минуты и секунды:

Для улучшения читаемости, год, месяц, день, часы, минуты и секунды могут быть разделены точками, тире или двоеточиями:

Также возможно обратиться ко всем снимкам указанного URL:

Все сохранённые страницы домена:

Все сохранённые страницы всех субдоменов

Чтобы обратиться к самой последней версии страницы в архиве или к самой старой, поддерживаются адреса вида:

Чтобы обратиться к определённой части длинной страницы имеется две опции:

В доменах поддерживаются национальные символы:

Обратите внимание, что при создании архивной копии страницы архивируемому сайту отправляется IP адрес человека, создающего снимок страницы. Это делается через заголовок X-Forwarded-For для правильного определения вашего региона и показа соответствующего содержимого.

web-arhive.ru

Архив интернет (Web archive) — это бесплатный сервис по поиску архивных копий сайтов. С помощью данного сервиса вы можете проверить внешний вид и содержимое страницы в сети интернет на определённую дату.

На момент написания, этот сервис, вроде бы, нормально не работает («Database Exception (#2002)»). Если у вас есть по нему какие-то новости, то пишите их в комментариях.

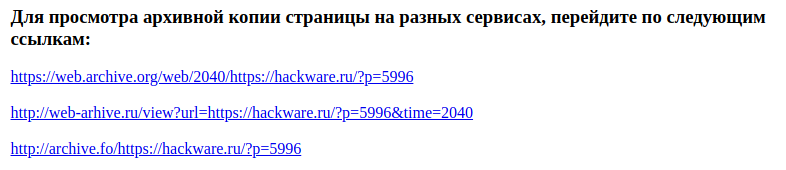

Поиск сразу по всем Веб-архивам

Может так случиться, что интересующая страница или файл отсутствует в веб архиве. В этом случае можно попытаться найти интересующую сохранённую страницу в другом Архиве Интернета. Специально для этого я сделал довольно простой сервис, который для введённого адреса даёт ссылки на снимки страницы в рассмотренных трёх архивах.

Что делать, если удалённая страница не сохранена ни в одном из архивов?

Архивы Интернета сохраняют страницы только если какой-то пользователь сделал на это запрос — они не имеют функции обходчиков и ищут новые страницы и ссылки. По этой причине возможно, что интересующая вас страница оказалась удалено до того, как была сохранена в каком-либо веб-архиве.

Тем не менее можно воспользоваться услугами поисковых движков, которые активно ищут новые ссылки и оперативно сохраняют новые страницы. Для показа страницы из кэша Google нужно в поиске Гугла ввести

Если ввести подобный запрос в поиск Google, то сразу будет открыта страница из кэша.

Для просмотра текстовой версии можно использовать ссылку вида:

Для просмотра исходного кода веб страницы из кэша Google используйте ссылку вида:

Например, текстовый вид:

Как полностью скачать сайт из веб-архива

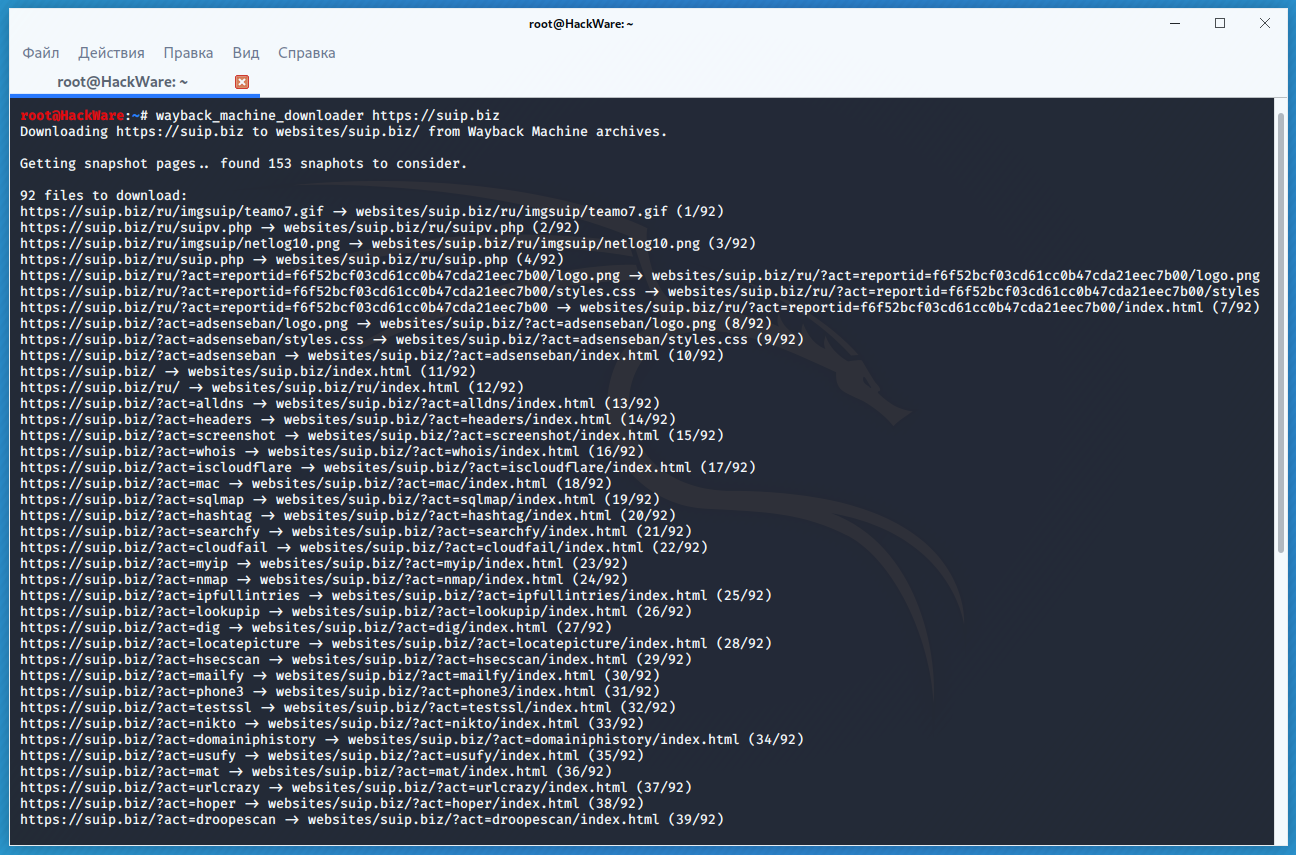

Если вы хотите восстановить удалённый сайт, то вам поможет программа Wayback Machine Downloader.

Программа загрузит последнюю версию каждого файла, присутствующего в Архиве Интернета Wayback Machine, и сохранить его в папку вида ./websites/example.com/. Она также пересоздаст структуру директорий и автоматически создаст страницы index.html чтобы скаченный сайт без каких либо изменений можно было бы поместить на веб-сервер Apache или Nginx.

Об установке программы и дополнительных опциях смотрите на странице https://kali.tools/?p=5211

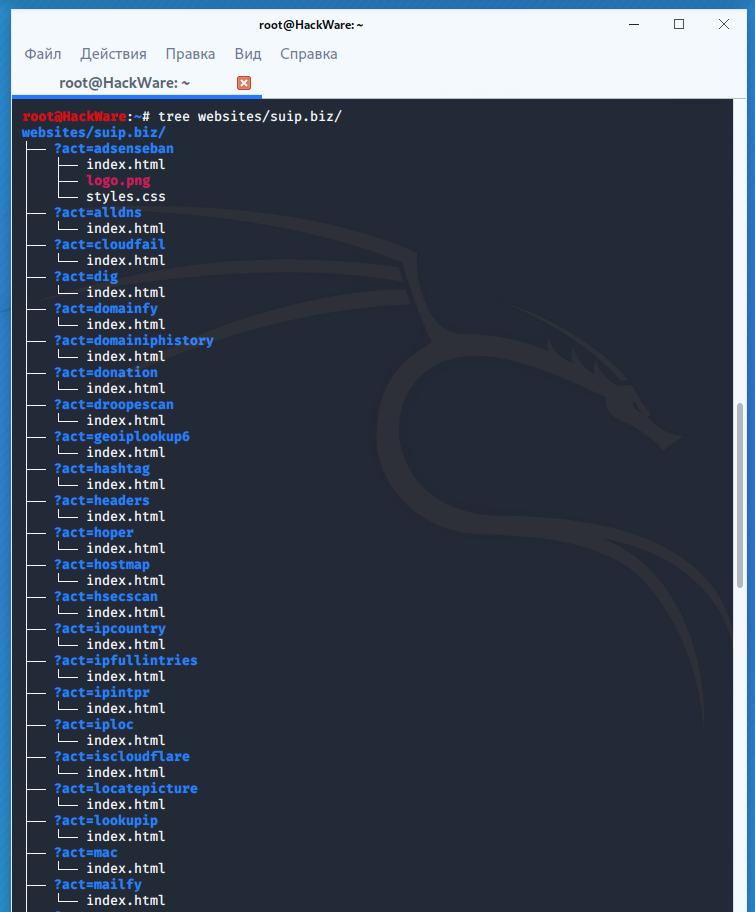

Пример скачивания полной копии сайта suip.biz из веб-архива:

Структура скаченных файлов:

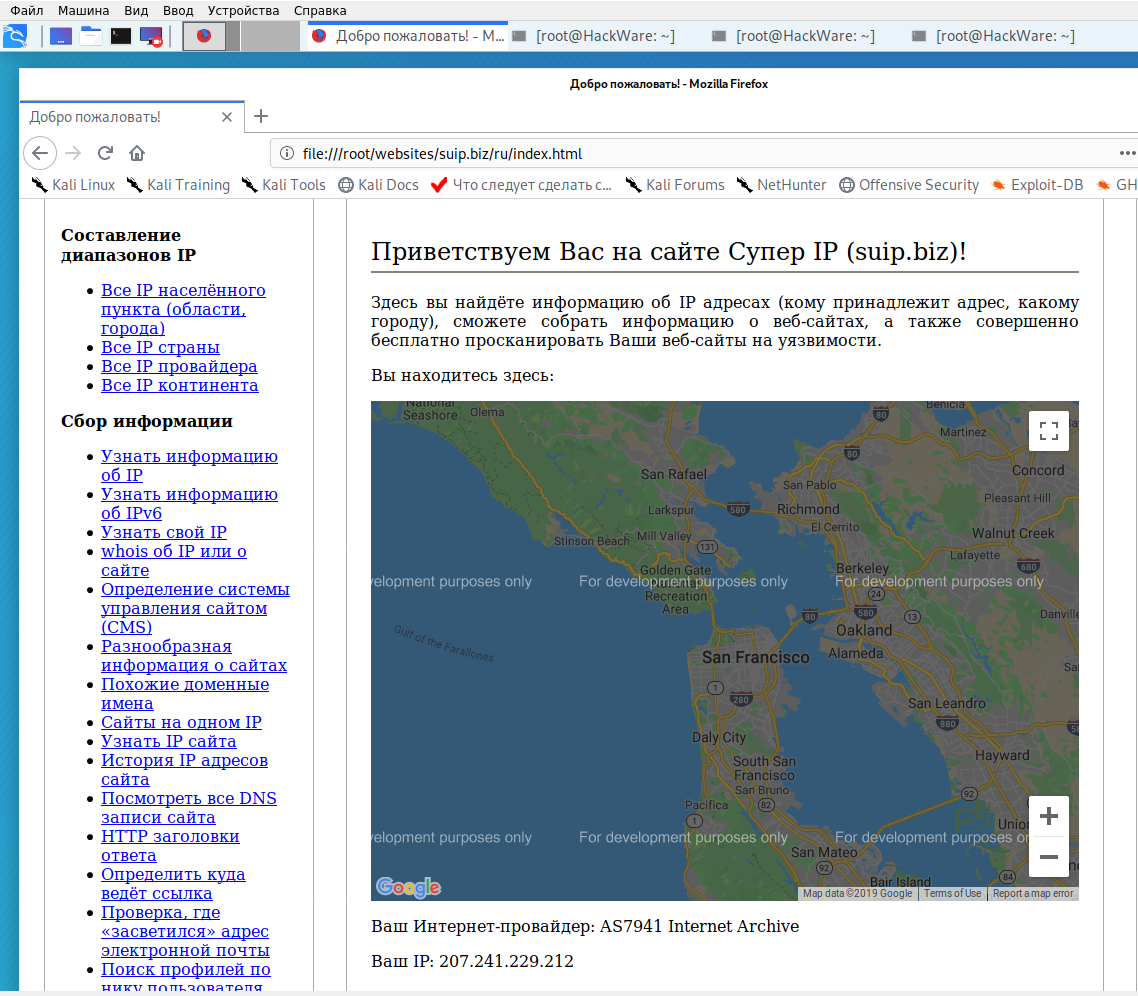

Локальная копия сайта, обратите внимание на провайдера Интернет услуг:

Как скачать все изменения страницы из веб-архива

Если вас интересует не весь сайт, а определённая страница, но при этом вам нужно проследить все изменения на ней, то в этом случае используйте программу Waybackpack.

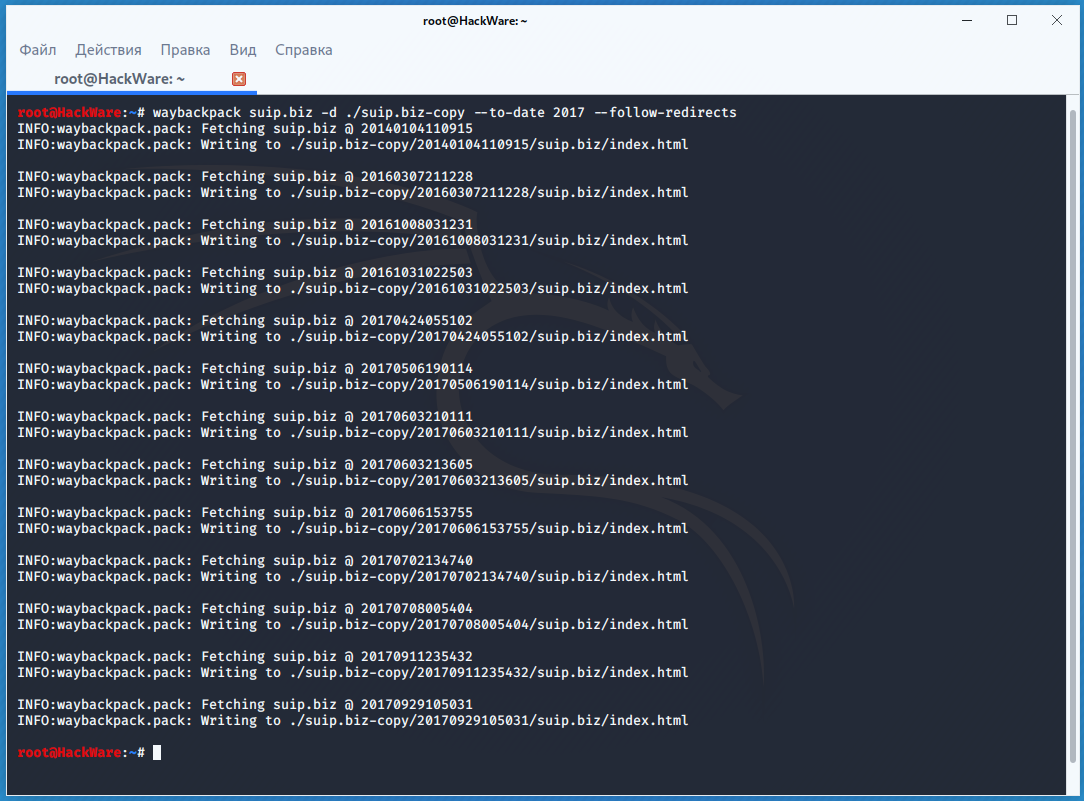

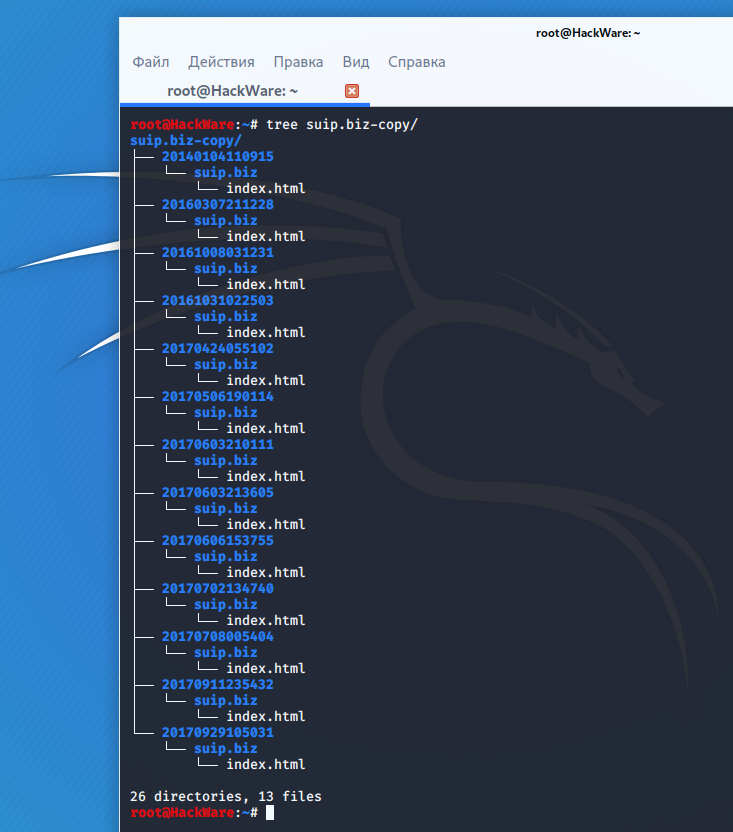

К примеру для скачивания всех копий главной страницы сайта suip.biz, начиная с даты (—to-date 2017), эти страницы должны быть помещены в папку (-d /home/mial/test), при этом программа должна следовать HTTP редиректам (—follow-redirects):

Чтобы для указанного сайта (hackware.ru) вывести список всех доступных копий в веб-архиве (—list):

Как узнать все страницы сайта, которые сохранены в веб-архиве

Для получения ссылок, которые хранятся в Архиве Интернета, используйте программу waybackurls.

Эта программа извлекает все URL указанного домена, о которых знает Wayback Machine. Это можно использовать для быстрого составления карты сайта.

Чтобы получить список всех страниц о которых знает Wayback Machine для домена suip.biz:

Заключение

Предыдущие три программы рассмотрены совсем кратко. Дополнительную информацию об их установке и об имеющихся опциях вы сможете найти по ссылкам на карточки этих программ.

Ещё парочка программ, которые работают с архивом интернета:

Как найти архивные копии сайтов интернета или машина времени для сайтов

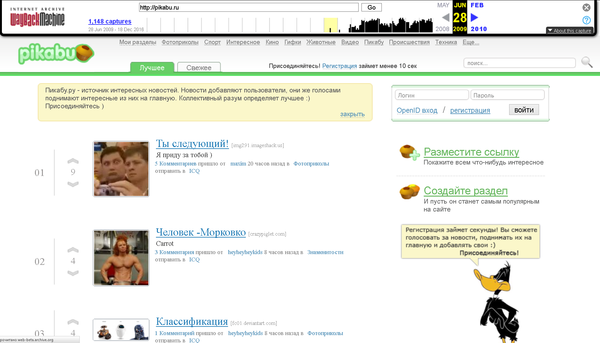

Первые дни Pikabu.ru

Существует настоящая, реальная машина времени, в которой можно ненадолго вернуться в прошлое и увидеть, например, как выглядел тот или иной сайт несколько лет назад. Думаете, никому не нужны копии сайтов многолетней давности? Ошибаетесь! Для очень многих людей сервис по архивированию информации весьма полезен.

Во-первых, это просто интересно! Из чистого любопытства и от избытка свободного времени можно посмотреть, как выглядел любимый, популярный ресурс на заре его рождения.

Во-вторых, далеко не все веб-мастера ведут свои архивы. Знать место, где можно найти информацию, которая была на сайте в какой-то момент, а потом пропала, не просто полезно, а очень важно.

В-третьих, само по себе сравнение является важнейшим методом анализа, который позволяет оценить ход и результаты нашей деятельности. Кстати, при проведении анализа веб-ресурса очень эффективно использовать ряд методов сравнения.

Поэтому наличие уникальнейшего архива веб-страниц интернета позволяет нам получить доступ к огромному количеству аудио-, видео- и текстовых материалов. По утверждению разработчиков, «интернет-архив» хранит больше материалов, чем любая библиотека мира. Мы попали в правильное место!

Что нужно, чтобы найти копии сайтов интернета?

Для того, чтобы отправиться в прошлое, нужно перейти на сайт https://web-beta.archive.org/ и воспользоваться поисковой строкой.

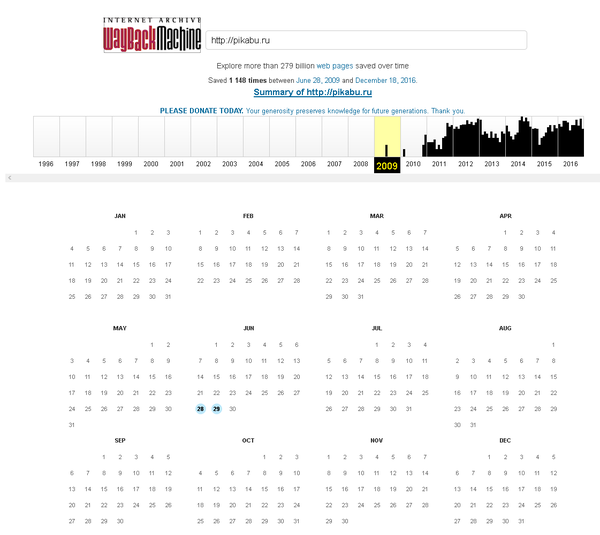

Простой поиск в архиве сохраненных сайтов выдает нам ссылки на все сохраненные копии запрашиваемой страницы.

Из этого скриншота видно, что сайт http://pikabu.ru был создан в 2009 году. Переключаясь на нужный нам год, можно увидеть даты, выделенные кружочками, это и есть даты сохранения копии сайта. Например, в 2009 году, пока можно будет увидеть только две копии от 28 и 29 июня.

Конечно, это потрясающий ресурс! Ведь здесь индексируются и архивируются все сайты интернета! Это не только скриншоты… Имея в руках такой инструмент, можно восстановить массу потерянной со временем информации.

Надо заметить, что, безусловно все восстановить однозначно не получится, так как если на страницах сайта используются элементы Java Script, или скрипты или графика взяты со стороннего сервера, то на восстановление такой информации рассчитывать не придется. Поэтому к сохранению данных своего сайта нужно относиться с особенным вниманием, несмотря ни на что.

Популярные веб-архивы и их применение

Каждый сайт — это история, которая имеет начало и конец. Но как проследить этапы становления проекта, его жизненный цикл? Для этих целей существует специальный сервис, который именуется веб-архивом. В этой статье мы поговорим о представлении подобных ресурсов, их использовании и возможностях.

Что такое веб-архив и зачем он нужен?

Веб-архив — это специализированный сайт, который предназначен для сбора информации о различных интернет-ресурсах. Робот осуществляет сохранение копии проектов в автоматическом и ручном режиме, все зависит лишь от площадки и системы сбора данных.

На текущий момент имеется несколько десятков сайтов со схожей механикой и задачами. Некоторые из них считаются частными, другие — открытыми для общественности некоммерческими проектами. Также ресурсы отличаются друг от друга частотой посещения, полнотой сохраняемой информации и возможностями использования полученной истории.

Как отмечают некоторые эксперты, страницы хранения информационных потоков считаются важной составляющей Web 2.0. То есть, частью идеологии развития сети интернет, которая находится в постоянной эволюции. Механика сбора весьма посредственная, но более продвинутых способов или аналогов не имеется. С использованием веб-архива можно решить несколько проблем: отслеживание информации во времени, восстановление утраченного сайта, поиск информации.

Как использовать веб-архив?

Как уже отмечалось выше, веб-архив — это сайт, который предоставляет определенного рода услуги по поиску в истории. Чтобы использовать проект, необходимо:

О специализированных сайтах для поиска исторического фиксирования проектов поговорим далее, поэтому оставайтесь с нами.

Проекты, предоставляющие историю сайта

Сегодня существует несколько проектов, которые предоставляют сервисные услуги по отысканию сохраненных копий. Вот некоторые из них:

Возможности использования веб-архивов

Теперь каждый знает, что такое веб-архив, какие сайты предоставляют услуги сохранения копий проектов. Но многие до сих пор не понимают, как использовать представленную информацию. Возможности архивных данных выражаются в следующем:

Мы рассмотрели основные возможности, которые предоставляют веб-архивы, самое время перейти к более подробному изучению отдельных элементов.

Восстанавливаем сайт из веб-архива

Никто не застрахован от проблем с сайтами. Большинство их них решается с использованием бэкапов. Но что делать, если сохраненной копии на сервере хостинга нет? Воспользоваться веб-архивом. Для этого следует:

Заметим, что процесс несколько утомительный, с учетом скорости работы архива. Поэтому рекомендуем владельцам больших веб-ресурсов чаще выполнять бэкапы, что сохранит время и нервы.

Ищем уникальный контент для собственного сайта

Некоторые веб-мастера используют интересный способ получения нового, никому не нужного контента. Ежедневно сотни сайтов уходят в небытие, а вместе с ними теряется информация. Чтобы стать владельцем контента, нужно выполнить следующее:

Рекомендуем отслеживать контент на наличие плагиата, это позволит найти действительно достойные тексты. А на этом все! Теперь каждый знает о возможностях и методах использования веб-архива. Используйте знание с умом и выгодой.

Webarchive — веб-архив всего интернета и сайтов или машина времени на archive.org

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Не так давно я писал про то, что такое народная энциклопедия Википедия, которая безусловно заслуживает всяких лестных эпитетов, несмотря на присущие ей небольшие недостатки и критику ее статей со стороны научного сообщества.

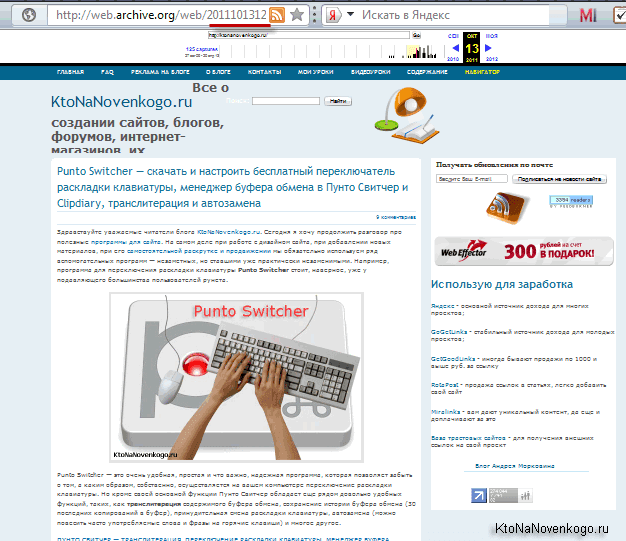

Сам факт того, что некоммерческий проект уже не одно десятилетие трудится на благо всего интернет сообщества, заслуживает огромного уважения. Но в сети есть еще подобный масштабный проект, который не получая с этого дохода выполняет очень важную роль — сохраняет архивы сайтов, видео, аудио и печатной продукции.

Я говорю, конечно же, про web.archive.org — глобальный проект с казалось бы невыполнимой миссией — создание архива всех сайтов, когда либо размещенных в интернете. Причем, сайты сохраняются не в виде скриншотов, а в виде полноценно работающих веб-страниц со всеми ссылками, картинками и стилевым оформлением (CSS). Причем, для каждого сайта за время его существования в сети в этом архиве может накопиться и по несколько сотен копий, датированных разными этапами жизни ресурса.

Как можно использовать архив сайтов интернета

Чем же может быть полезен данный webarchive?

Ну, и последнее, что приходит в голову — поиск уникального контента. Если вы не способны сами создавать уникальный контента для сайта (писать статьи), то здесь вы сможете ими разжиться, правда, усилия приложить все равно придется. Суть такова, что многие сайты умирают и становятся недоступны вместе с имеющимся на них контентом.

Отыскав такие ресурсы вы сможете вытащить тексты из интернет-архива и разместить их у себя, предварительно проверив их на уникальность. Таким образом вы не занимаетесь плагиатом и не нарушаете авторские права (копирайт), но искать в вебархиве многим может показаться очень уж трудоемкой задачей.

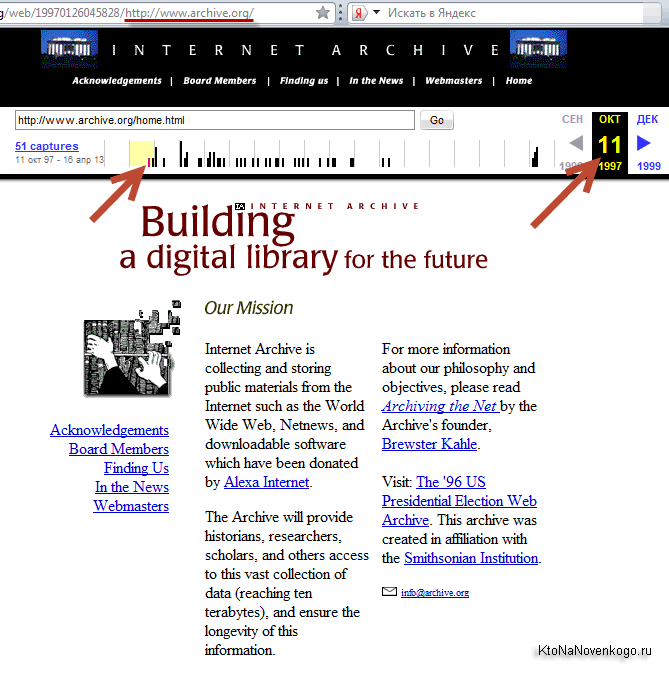

Онлайн сервис Webarchive ведет свою историю аж с 1996 года. Поставленная перед проектом задача казалась невыполнимой даже с учетом того, что сайтов на то время в интернете было значительно меньше, чем сейчас (на несколько порядков). По началу, сайты архивировались не очень часто, но со временем, повышая мощности хранилищ, Веб-архив стал делать все больше и больше слепков сайтов.

Сам себя этот веб архив занес в базу лишь в 1997 году и выглядела его главная страница тогда так:

Сейчас на все про все (включая аудио, видео и отсканированные книги) у этой некоммерческой организации задействовано дисковое пространство чудовищных размеров, измеряемое десяткой с пятнадцатью нулями байт. Сайт имеет зеркала в различных дата центрах, а сам проект с недавних пор получил официальный статус библиотеки. Если рассматривать только архив страниц сайтов, то их уже там насчитывается около ста миллиардов (тут учитываются все слепки страниц когда-либо снятые и сохраненные).

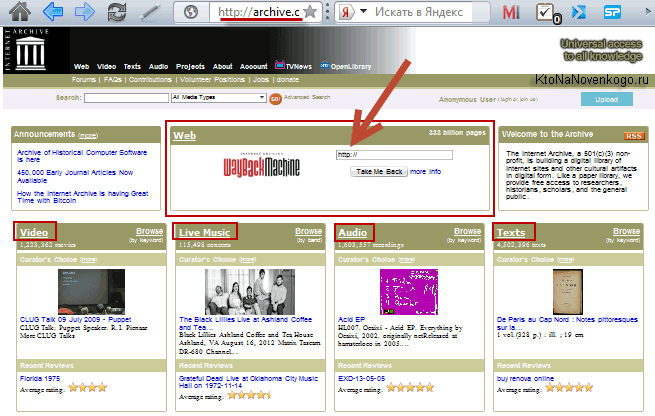

На главной странице доступен не только архив страниц интернета Wayback Machine, но и архивы различных кинохроник, телепередач, аудио записей и отсканированных в различных библиотеках книг:

Но нас интересует именно область WEB с логотипом Wayback Machine. В расположенную там форму можно ввести URL или доменное имя интересующего вас сайта (читайте про то, что такое домен и чем он отличается от URL), чтобы попасть на страницу с календарем:

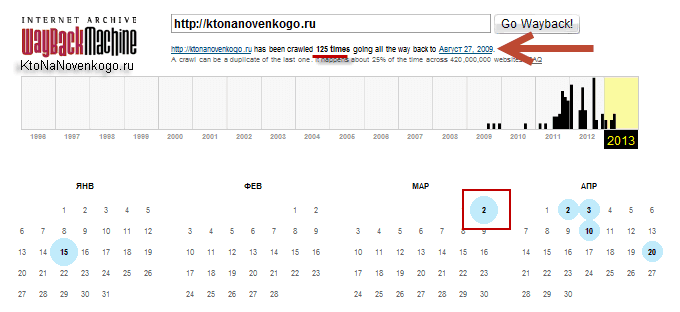

Из приведенного примера видно, что мой блог был впервые архивирован 27 августа 2009 года (через пять дней после регистрации (покупки) домена ktonanovenkogo.ru). За прошедший интервал времени было создано 125 архивных копий сайта, каждую из которым можно будет посмотреть и потрогать руками (осуществляя переходы по внутренним ссылкам).

Открытие мертвых ссылок и условия попадания сайта в archive.org

В календаре голубыми кружочками отмечены даты, в которые был создан слепок (вебархив) данного сайта. Естественно, что моменты снятия слепка никак не будет коррелироваться с производимыми на вашем ресурсе изменениями, и их время Webarchive определяет строго исходя из своих внутренних алгоритмов и таймеров.

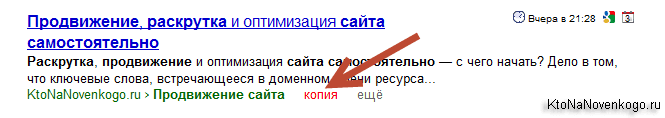

Поэтому использовать архив интернета, как инструмент для открытия временно недоступных сайтов, наверное, не всегда будет резонным. Для этого у Яндекса имеется возможность просмотра архивной копии документа:

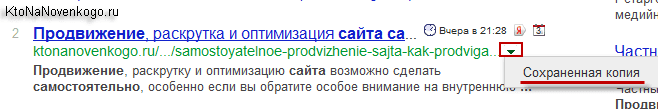

Да, и в Google можно всегда посмотреть сохраненную копию веб-страницы:

Данный же онлайн сервис понадобится в особо тяжелых случаях, когда искомая страница уже не существует и вряд ли уже будет существовать в реальном интернете, но зато она по прежнему будет доступна в машине времени.

Правда, тут должно быть соблюдено несколько условий того, чтобы сайт попал в archive.org:

Он не должен содержать в своем файле robots.txt запрет для его индексации роботом с web.archive.org. Такой запрет, обычно выглядит так:

Когда я писал статью про электронную почту mail.ru, то не смог найти в Архиве Интернета сохраненных копий сайта mail.ru, т.к. его файл robots.txt содержал в себе похожий запрет:

Как найти нужный веб-архив и восстановить сайт без бекапа

По архивам можно перемещаться и с помощью временной шкалы расположенной вверху страницы, где вертикальными черными черточками отмечены имеющиеся для этого сайта слепки. Иногда, веб-архивы могут быть битыми, тогда придется открыть ближайший к нему слепок.

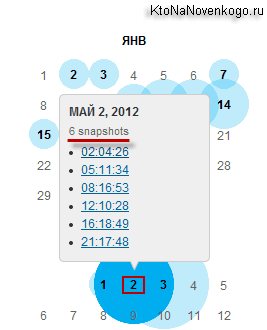

Щелкнув по голубому кружочку мы можем увидеть ссылки на несколько архивов, отличающихся временем их снятия.

Возможно, что это делается во избежании потери данных за счет неизбежной порчи жестких дисков в хранилищах. Перейдя к просмотру одного из веб-архивов, вы увидите копию своего (в данном примере моего) сайта с работающими внутренними ссылками и подключенным стилевым оформлением. Правда, не идеально работающим.

Например, кое-что из дизайна у меня все же перекосило и боковое меню работающее на ДжаваСкрипте полностью исчезло:

Но это не столь важно, ибо в исходном коде страницы с web.archive.org это меню, естественно, присутствует. Однако, просто так скопировать текст этой страницы к себе на сайт взамен утерянной не получится. Почему? Да потому что путешествие внутри сайта из прошлого будет возможно лишь в случае замены всех внутренних ссылок на те, что генерит Webarchive (в противном случае вас перебросило бы на современную версию ресурса).

Выглядят эти ссылки примерно так:

Понятно, что можно будет вручную отсечь вступительную часть ссылок ( http://web.archive.org/web/20111013120145/ ), получив таким образом рабочий вариант. Можно этот процесс даже автоматизировать с помощью инструмента поиска и замены редактора Notepad, но еще проще будет воспользоваться встроенной в этот сервис возможностью замены внутренних ссылок на оригинальные.

Для этого копируете адрес страницы с нужным слепком вашего сайта (из адресной строки браузера — начинается с http://web.archive.org/ ). Он будет иметь примерно такой вид:

И вставляете в него конструкцию «id_» в конце даты ( 20111013120145 ), чтобы получилось так:

Теперь измененный адрес обратно возвращаете в адресную строку браузера и жмете на Enter. После этого страница c архивом вашего сайта обновится и все внутренние ссылки станут прямыми. Можно будет копировать текст статьи из исходного кода вебархива.

Понятно, что восстановление таким образом огромного сайта займет чудовищное количество времени, но когда другого варианта нет, то и такой покажется манной небесной. К тому же, страдают невозвратной потерей контента обычно только начинающие вебмастера, у которых этого самого контента было мало, а более-менее опытные сайтовладельцы, уж не раз обжигавшиеся на подобных вещах, делают бэкапы файлов и базы по пять раз на дню.

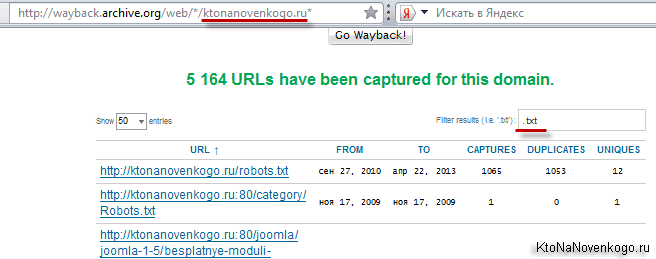

Если вы захотите увидеть все страницы вашего (или чужого) сайта, которые содержатся в недрах этого мастодонта, то вам нужно будет вставить в адресную строку браузера следующий адрес и нажать Enter:

Вместо моего домена можно использовать свой. На открывшейся странице вы получите возможность наложить фильтр в предназначенной для этого форме:

Например, я захотел увидеть лишь текстовые файлы своего блога, которые заглотил Web Archive. Зачем — не знаю, но захотел.

Как вытянуть из Webarchive уникальный контент для сайта

Описанный ниже способ лично я не использовал, но чисто теоретически все должно работать. Саму идею я почерпнул на этом молодом ресурсе, где и были описаны все шаги. Принцип метода состоит в том, что каждый день умирают и никогда не возрождаются десятки сайтов.

Причин этому может быть много и большинство из почивших в бозе ресурсов никакой особой ценности в плане контента никогда и не представляли. Но из всякого правила бывают исключения и нужно будет всего-навсего отделить зерна от плевел. Главное чтобы исчезнувшие сайты с более-менее удобоваримым контентом были бы представлены в Web Archive, хотя бы одной копией.

Т.к. после смерти контент этих сайтов постепенно выпадет из индекса поисковых систем, то взяв его из интернет-архива вы, по идее, станете его законным владельцем и первоисточником для поисковых систем. Замечательно, если будет именно так (есть вариант, что еще при жизни ресурса его нещадно могли откопипастить). Но кроме проблемы уникальности текстов, существует проблема их отыскания.

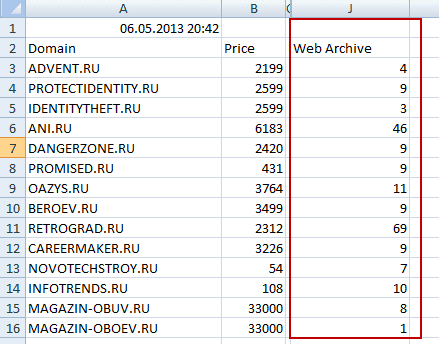

Во-первых, нам нужен список сайтов, которые скоро умрут или уже померли. Автор метода предлагает скачать с сайта регистратора доменных имен Nic.ru список освобождающихся или уже освободившихся доменов.

Что примечательно, в последней колонке этого списка (его можно открыть в Excel) будет отображаться количество архивов, созданных для каждого сайта в Web Archive (правда, проверить наличие домена в веб-архиве можно и в ряде онлайн сервисов).

Список буржуйских доменных имен, освобождающихся или уже освободившихся, предлагается скачать по этой ссылке. Ну, а дальше просматриваем содержимое сайтов, которое сохранил Web Archive и пытаемся найти что-то стоящее. Потом проверяем уникальность этих материалов (ссылку приводил чуть выше) и в случае удачи публикуем их на своем ресурсе, либо продаем в какой-нибудь бирже контента.

Да, способ муторный и мною лично не проверенный. Но, думаю, что при некоторой степени автоматизации и обмозговывания он может давать неплохой выхлоп. Наверное, кто-нибудь уже это поставил на поток. А вы как думаете?

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Комментарии и отзывы (18)

То, что текст из вебархива уникальный на данный момент, совсем не значит что ПС про него не знают или забыли после того, как сайт умер. Так что тут надо осторожно.

хм, так вот он этот способ о котором я так много слыхал. Часто всякие умники пишут ухмыляясь что знают как достать уникальный контент очень дешего )))

Класс буду использовать 100%.

Интересно, а картинки с «почивших» сайтов также можно использовать как уникальные?

Очень здорово все описано, спасибо за ценную информацию, как всегда все доступно и подробно.

Webarchive — замечательная весч. Иногда даже бывает очень нужна, если не помнишь как выглядел тот или иной сайт. Или выцепить код, рипнуть ))

За статью автору отдельное спасибо!

Тяжкий труд выискивать уникальный контент в Вэбархиве, с учетом того, что сайты с такими материалами в легкую уходят под фильтр. И не надо слушать толкателей псевдокейсов кейсов, что это не так.

Дмитрий помогите пожалуйста, нашел несколько интересных сайтов по моей тематике, однако при попытке просмотреть их архив все они требуют работы кукисов. Все мои браузеры их принимают, настройки проверял, однако выдается такое сообщение «Этот сайт требует поддержки технологии Cookies»

Возможно что-нибудь сделать?

Восстановление сайтов из архива — отличный, быстрый способ получить уникальный контент для Ваших проектов.

Восстанавление сайта из веб-архива (archive.org) http://vk.com/archive_org

При проверки большества сайтов — получаю ответ:

You don’t have permission to access / on this server.

Этот сайт требует поддержки технологии Cookies.

можно как то это обойти или решить проблему человеческим способом?

Помню раньше сайтец посещал про магические всякие штучки-дрючки,очень понравился. А потом админ перевела его на немецкий домен, который благополучно накрылся медным тазом. Восстанавливать сайт админ даже и не думала, а контактов не осталось, вот и решил я его сам из архива вытащить и реставрировать.

Глянул в веб архиве — всё норм.

Заплатил я за аккаунт в онлайн парсере, хотел сайт вытащить а там такая фигня:

The requested URL /welcome.php was not found on this server.

Apache/2.2.16 (Debian) Server at witches.onio.de Port 80

Ни один снапшот не доступен. Это что уже всё, кранты, снапшоты навсегда утеряны?

(хотел обратится в поддержку, но к своему стыду, даже не смог найти их электронную почту)

Саму идею я почерпнул на этом молодом ресурсе, — а ресурс то умер.

Заметно что вебархив хранит не только живые(в прошлом) страницы, но и 404-редиректы хостера после того как ваш счет был закрыт. Из-за этого создается впечатление что снепшотов для сайта много, а на самом деле мусор(.

Ваша статья мне очень помогла. Большое спасибо!

Тема мертва, а тексты из вебархива больше вредят сайтам. Доказано неоднократно.

Сегодня возникла необходимость поднять страницу из веб-архива, и знаете что? Веб-архив числится в списке запрещенных сайтов минюста РФ))

Скажите, а Вебархив видит страницы раньше того же Гугла или позже? Нет ли у Гугла такого же аналога, где можно было бы посмотреть, на каком сайте первым проиндексировалась страница? Например есть ряд страниц, которые по Вебархиву первыми проиндексировались у копипастера, но так ли это в Гугл? Проверять по кавычкам не вариант, сайт за что-то под Пандой (рассматривается и это как вариант), все тексты в кавычках не первые.

Заметно что вебархив хранит не только живые(в прошлом) страницы, но и 404-редиректы хостера после того как ваш счет был закрыт. Из-за этого создается впечатление что снепшотов для сайта много, а на самом деле мусор(.

Я Вам даже больше скажу — он ещё и не все сайты сохраняет, и в большинстве случаев даже то что сохраняет тоже мусор. Да и кстати нет смысла все подряд сохранять.